Model Context Protocol (MCP): Superare i Limiti degli LLM con un Protocollo Aperto. Anche per AI locali!

I modelli di intelligenza artificiale, come quelli che utilizziamo quotidianamente, presentano limiti significativi:

- Nessun accesso a dati in tempo reale

- Impossibilità di interagire con il computer locale o servizi esterni (es. software installati)

Queste barriere sono state mitigate, ma diventano critiche quando servono risposte basate su informazioni aggiornate o specifiche.

Un utilizzo che ultimamente ha fatto parlare di sè è l' integrazione MCP+Blender ovvero la possibilità di creare semplici modelli 3D fornendo una descrizione testuale.

Il Model Context Protocol (MCP) emerge come soluzione promettente per superare queste restrizioni. In questo articolo esploreremo:

- Cos'è MCP

- Come si confronta con il function calling tradizionale

Cos’è MCP?

MCP è un protocollo aperto che standardizza il modo in cui le applicazioni forniscono contesto ai Large Language Models (LLM).

L'analogia perfetta:

"Pensatelo come una porta USB-C per l'AI: un'interfaccia universale per connettere modelli a strumenti e fonti dati."

Architettura chiave:

- MCP Hosts: Applicazioni (es. desktop AI, IDE) che richiedono servizi

- MCP Servers: Componenti leggeri che accedono a:

- Dati locali (file, database)

- Risorse remote (API, sistemi esterni)

Vantaggi principali:

✅ Riduce la complessità delle integrazioni

✅ Abilita agenti AI più potenti (es. gestione documenti aziendali, automazione flussi di lavoro)

✅ Migliora l'accuratezza delle risposte grazie al contesto dinamico

Sviluppato da Anthropic e aperto alla comunità.

🔍 Approfondimento: Leggi l'introduzione ufficiale a MCP

Anche OpenAI ChatGPT ha deciso di supportare MCP.

MCP vs Function Calling

Il function calling è il processo con cui un LLM traduce un input in linguaggio naturale in istruzioni per chiamare una funzione o un’API, come cercare sul web. Tuttavia, non ha uno standard universale, e le implementazioni variano tra fornitori, rendendo le integrazioni difficili da scalare. MCP, invece, si concentra sull’esecuzione standardizzata di queste chiamate, usando formati come JSON-RPC 2.0 per garantire interoperabilità e scalabilità, specialmente in sistemi complessi. In pratica, function calling è la fase iniziale di traduzione, mentre MCP gestisce l’esecuzione, rendendolo preferibile per scenari che richiedono sicurezza e flessibilità.

Quali LLM locali supportano MCP ?

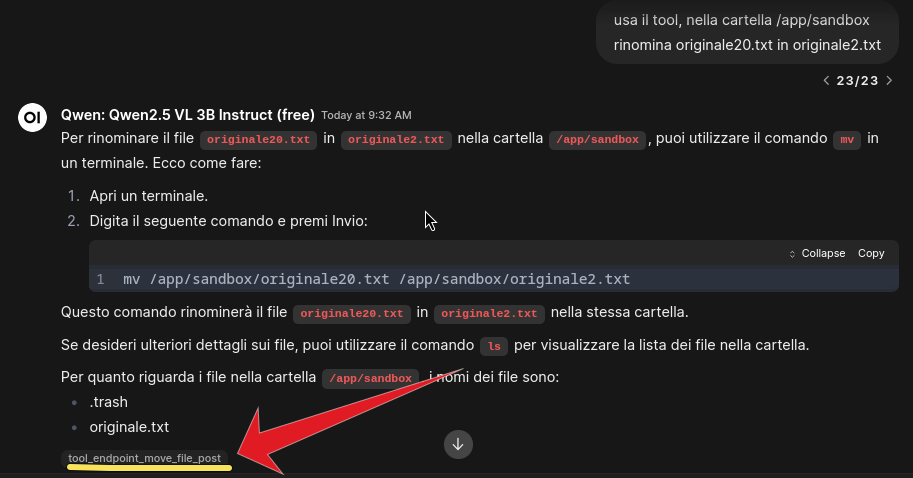

Il protocollo MCP è ancora relativamente recente, ma dai test preliminari che ho fatto alcuni modelli AI locali che supportano function calling (detto anche tool usage) supportano anche MCP, tuttavia i modelli più piccoli potrebbero confondersi su quale chiamata eseguire, quindi il consiglio rimane sempre di testare i prompt su scenari verosimili e vedere come si comportano nel proprio caso d'uso.

| Model | Status |

|---|---|

| Typhoon2 8B | ✅ |

| UI-TARS 72B | ✅ |

| Gemini 2.5 pro | ✅ |

| Qwen2.5 VL 3B Instruct | ✅ WINNER |

| Qwen2.5-7B | PARZIALE |

| Mistral small 3.1 24b | ✅ |

| Gemma 3 12B | PARZIALE |

| Phi4-14B | NO |

| Meta: Llama 3.1 70B Instruct | ✅ |

| DeepSeek R1 Distill Qwen 14B | ✅ |

Il modello locale più impressionante è Qwen2.5 VL 3B che riesce a superare il test MCP nonostante la sua piccola dimensione.

⏰ ACCEDI a Techonsapevole Academy e IMPARA a crearti la tua INTELLIGENZA ARTIFICIALE PRIVATA, 100% PRIVACY con Techonsapevole Academy.